爬虫技术是利用自动化手段获取网页信息的技术,简单明了地解析。

在当今数字化时代,互联网上的信息量与日俱增,如何高效地获取、处理这些信息成为了一项重要的技术挑战,在这样的背景下,爬虫技术应运而生,成为了信息获取的关键工具之一,究竟什么是爬虫技术呢?本文将用通俗易懂的语言为您解析这一概念。

爬虫技术的定义

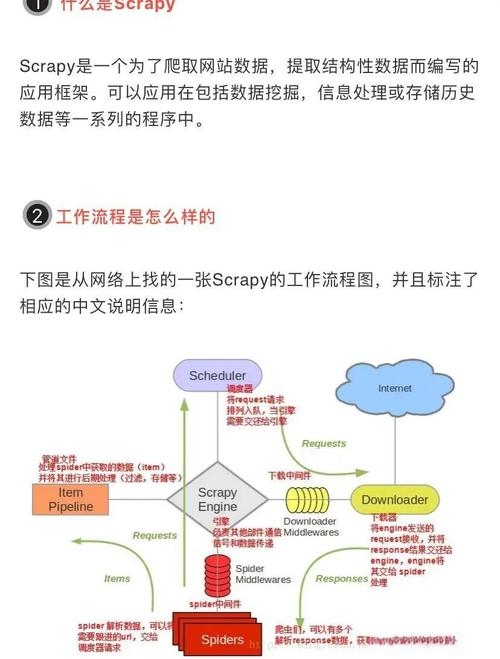

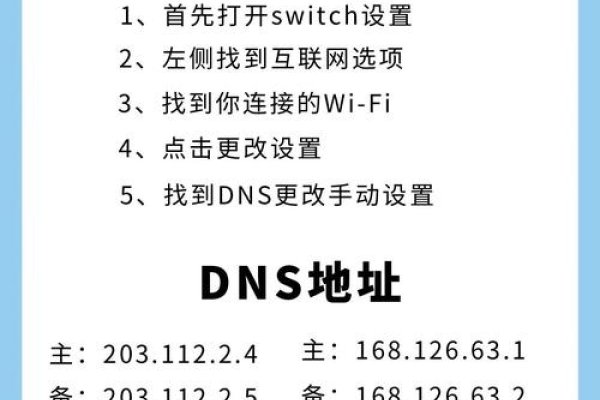

爬虫,顾名思义,是一种能够在互联网上自动抓取、分析数据的程序,它的工作原理类似于我们在网页上浏览信息时,通过浏览器向服务器发送请求,获取网页内容,而爬虫技术则是模拟这一行为,通过编写程序实现自动化操作,从而获取目标网站的数据。

爬虫技术的应用场景

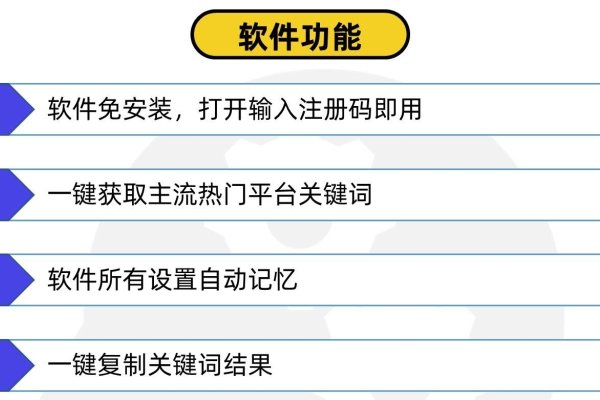

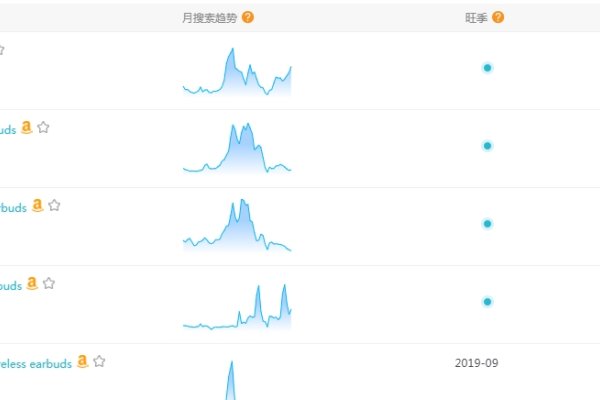

- 数据采集:爬虫技术可以自动抓取网页上的数据,如商品价格、新闻资讯等,为企业的决策分析、市场调研等提供数据支持。

- 搜索引擎:搜索引擎需要不断地收集互联网上的信息,以便用户搜索,爬虫技术在其中扮演了重要角色,负责抓取网页内容并建立索引。

- 数据分析与挖掘:通过爬虫技术获取的大量数据,可以进行进一步的分析与挖掘,发现数据间的关联和规律,为企业的产品研发、市场预测等提供支持。

爬虫技术的通俗解释

如果我们把互联网比作一座巨大的图书馆,那么爬虫技术就相当于一个自动抄书机,这个机器可以自动打开图书的每一页,读取上面的内容,然后把这些内容整理起来供我们查阅,这样,我们就不需要一页一页地去翻阅,大大提高了获取信息的效率。

爬虫技术的合法使用

需要注意的是,在使用爬虫技术时,我们必须遵守网站的爬虫协议和相关法律法规,不能非法获取、使用他人的数据,否则可能面临法律风险。

爬虫技术作为一种高效的信息获取工具,在互联网时代发挥着重要作用,通过通俗易懂地解析,我们可以更好地理解其工作原理和应用场景,在合法合规的前提下,合理利用爬虫技术,将为我们的工作和生活带来更多便利。