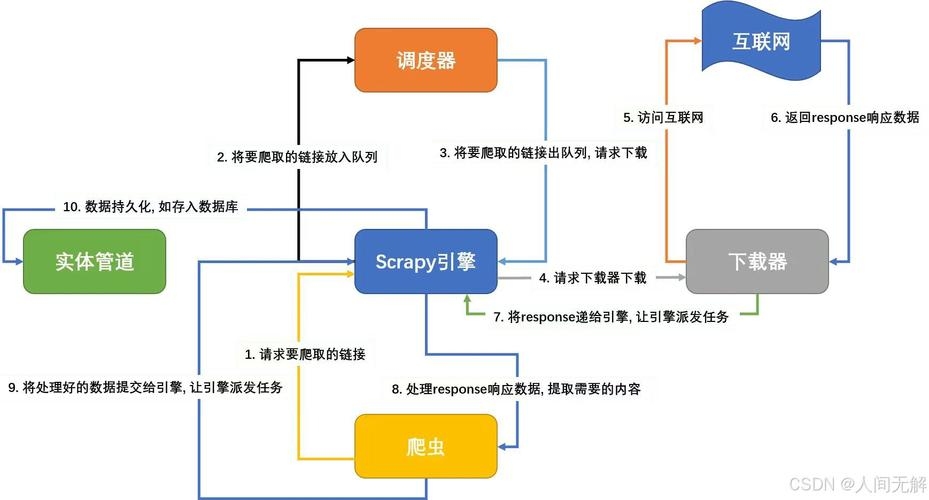

爬虫的基本流程包括:确定目标网站、发送请求获取网页内容、解析网页提取所需数据、存储数据或进一步处理,在执行过程中,需注意遵守网站规定,避免频繁请求导致被封禁,整个流程需确保爬虫的效率与准确性,以达到有效获取、处理及利用数据的目的。

在当今互联网时代,数据的重要性不言而喻,而爬虫作为一种获取数据的重要手段,其基本流程的掌握对于数据获取和处理至关重要,本文将详细介绍爬虫的基本流程,帮助读者更好地理解和应用爬虫技术。

爬虫基本流程

确定目标网站

需要确定要爬取数据的网站,这需要分析网站的数据结构、URL规则以及反爬虫策略等,以便更好地制定爬取策略。

发送请求

确定目标网站后,需要使用爬虫程序向目标网站发送请求,这个过程需要模拟浏览器行为,包括设置请求头、请求参数等,以便让目标网站误以为是一个真实的用户请求。

获取响应数据

发送请求后,等待目标网站的响应,响应数据通常以HTML、JSON或XML等格式返回,这些数据包含了我们需要爬取的信息。

解析数据

获取响应数据后,需要使用解析器对数据进行解析,解析器可以根据数据的格式选择不同的解析方式,如正则表达式、BeautifulSoup(针对HTML)或JSON/XML解析器等,通过解析器,我们可以提取出我们需要的数据。

数据存储

提取出数据后,需要将其存储起来以便后续处理,存储方式可以根据需求选择,如保存到本地文件、数据库或缓存等。

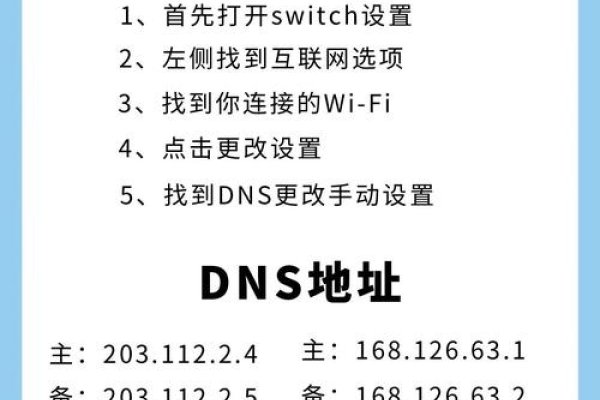

反爬虫策略应对

在爬取数据过程中,可能会遇到目标网站的反爬虫策略,为了应对这些策略,我们需要采取相应的措施,如设置请求间隔、使用代理IP、设置User-Agent等,这些措施可以降低被目标网站封禁的风险。

循环爬取

对于需要爬取大量数据的网站,可以采用循环爬取的方式,即根据URL规则生成新的URL,然后重复以上步骤进行爬取,在循环爬取过程中,需要注意避免重复爬取和死循环等问题。

本文详细介绍了爬虫的基本流程,包括确定目标网站、发送请求、获取响应数据、解析数据、数据存储、反爬虫策略应对和循环爬取等步骤,掌握这些基本流程对于数据获取和处理具有重要意义,在实际应用中,还需要根据具体需求和目标网站的特性进行相应的调整和优化,需要注意遵守相关法律法规和道德规范,避免侵犯他人权益和违反相关法律法规的行为。